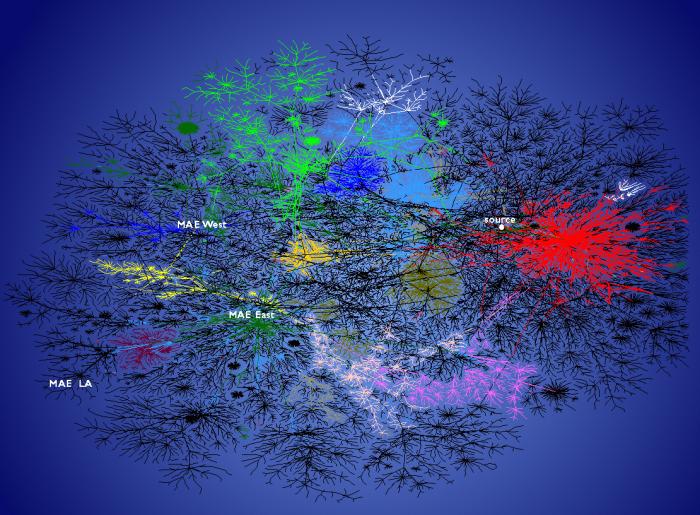

I modelli individuati nello studio delle reti complesse sono serviti anche a dare una spiegazione di alcune dinamiche sociali.

Uno studio della University of Michigan Business School di qualche anno fa ha messo in luce la struttura di

piccolo mondo nella rete di relazioni tra i dirigenti che siedono nei consigli di amministrazione delle grandi

corporate americane: è come dire che questi personaggi, che influiscono più o meno direttamente nell'andamento dell'economia statunitense, partecipano in una rete relazionale in cui con poche strette di mano si può raggiungere uno qualunque degli importanti

decision maker della elìte di manager della crema del mondo economico e finanziario a stelle e strisce.

Davis e altri hanno dimostrato che i legami interni a tale rete influiscono parecchio sulla comunità economico-finanziaria. Per esempio le aziende nei cui consigli di amministrazione siedono numerosi funzionari di istituti bancari prendono più spesso in prestito il denaro, e questo fa pensare che il legame con i banchieri influenzi le loro decisioni. In genere le relazioni interaziendali servono a diffondere le informazioni, rendere omologo l'atteggiamento dei vari consigli di amministrazione, permettere all'industria di intuire quanto accade nei diversi settori dell'economia.

Mark Buchanan - Nexus.

Lasciata a sé stante, il sistema delle relazioni tra i consigli di amministrazione assumerà sempre una struttura di piccolo mondo.

Va da sé che quanto è risultato evidente nel mondo della finanza e dell'industria americano ha validità anche in altre organizzazioni.

Nessuno ha mai compiuto, che io sappia, un analogo studio riguardo le relazioni che sussistono tra gli uomini che occupano i luoghi del potere politico, ma non mi sembra azzardato affermare che la rete di connessioni anche in quel caso ha una natura dello stesso genere,

small world con pochi passaggi tra due qualunque personaggi politici.

Infatti ciascun uomo politico è un nodo di una rete di relazioni, che si estende verso le segreterie dei partiti amici ma anche di quelli avversari, verso le istituzioni e gli uomini degli apparati statali, verso i circoli territoriali e i politici che mobilitano localmente gli elettori, verso le testate giornalistiche e le direzioni dei telegiornali, verso i think

tank che alimentano il dibattito politico intellettuale, verso le unioni dei lavoratori e i sindacati, verso le confederazioni economiche, gli istituti finanziari, e chi più ne ha più ne metta. Nel corso della propria carriera politica ognuno di questi personaggi compie sforzi per acquisire un maggiore numero di legami, di connessioni: segue cioè lo stesso meccanismo di crescita che Barabasi ha riscontrato alla base della formazione degli

hub. In ultima analisi, un politico influente è un

hub di questa rete complessa, con un elevato o elevatissimo grado di connessioni.

La teoria delle reti complesse di tipo aristocratico - quella di Barabasi appunto - offre un'efficace rappresentazione ai possibili scenari politici di una società umana.

Una rete con un solo hub, unico e iperconnesso, è certamente ancora una rete piccolo mondo: essa può rappresentare la rete delle relazioni tra un dittatore o un re ed i propri sudditi.

Una rete con un hub che raccoglie una diversità di hub più piccoli che a loro volta raccolgono dei sudditi, può rappresentare una monarchia in cui si sia formata una classe di nobili feudatari ad esempio.

Un numero limitato di hub iperconnessi, seguito da un numero maggiore di hub con un inferiore grado di connettività, e giù fino ad un enorme numero di individui (gli elettori anonimi) con poche connessioni, potrebbe essere una rappresentazione di un'evoluta democrazia occidentale, opulenta e corrotta, come l'Italia (tanto per fare un esempio).

Ho già osservato in passato che una società del genere può difficilmente evolvere spontaneamente verso un maggiore grado di eguaglianza: il sistema degli hub iperconnessi presenta una certa resilienza, per cui nel caso della scomparsa di uno di essi (ovvero della formazione di un vuoto di potere) un nuovo hub ne prenderebbe il posto: sia esso uno dei giganti iperconnessi già esistenti, oppure la promozione di uno degli hub immediatamente più in basso nella scala della connettività.

Una società del genere è naturalmente ancora una democrazia, in cui gli incarichi politici sono passati da un hub ad un altro, ed in cui gli esponenti politici affermati possono ancora cadere in disgrazia e scomparire dalla scena. Ma, come nel caso della rete dei consiglieri di amministrazione delle grandi corporate americane, una organizzazione siffatta tende a rendere omologo l'atteggiamento degli hub ed a limitare e condizionare l'affiorare di nuovi hub - e questo certamente dovrebbe farci riflettere.

La semplicità asettica del modello di rete aristocratico di Barabasi ha una grossa base scientifica per quanto riguarda l'organizzazione di molti sistemi complessi che sono stati oggetti di studio scientifico. L'estensione di questo concetto alla organizzazione politica della nostra società occidentale è un'estrapolazione personale, di cui non penso che esista una dimostrazione scientifica: se ne trovate una, come al solito, vi prego di segnalarmela.

Ciononostante, leggendo queste cose, penso che a più d'uno sia venuto in mente il parallelo nei termini in cui lo ho condotto io.

Ma se l'organizzazione di piccolo mondo è un requisito probabilmente imprescindibile di una società, non lo è la topologia aristocratica di Barabasi. Ci vengono in soccorso le reti di Watts-Strogatz, piccoli mondi con topologie più egualitarie, dove gli hub non dominano incontrastati. Esse si possono formare durante il processo di crescita continua di una rete aristocratica quando intervenga un meccanismo di limitazione della crescita:

Le reti piccolo mondo di tipo egualitario [...] sono molto più che mere curiosità matematiche. Come le reti aristocratiche di Internet o del World Wide Web, si formano attraverso un semplice processo storico di crescita. Ogniqualvolta intervengono costi o limiti che impediscono ai ricchi di arricchirsi ulteriormente, la rete piccolo mondo diventa più egualitaria [...].

Mark Buchanan - Nexus.

Allora il problema si risolve facilmente: dobbiamo solo mettere qualche limitazione alla "crescita" incontrollata del nostro corrotto sistema politico. Neanche a dirlo, introdurre limitazioni alla crescita matematicamente equivale a ridurre letteralmente la distanza tra hub ed elettori, ad avvicinare i luoghi del potere ai cittadini.